Nachvollziehbare KI-Entscheidungen

Relevanz

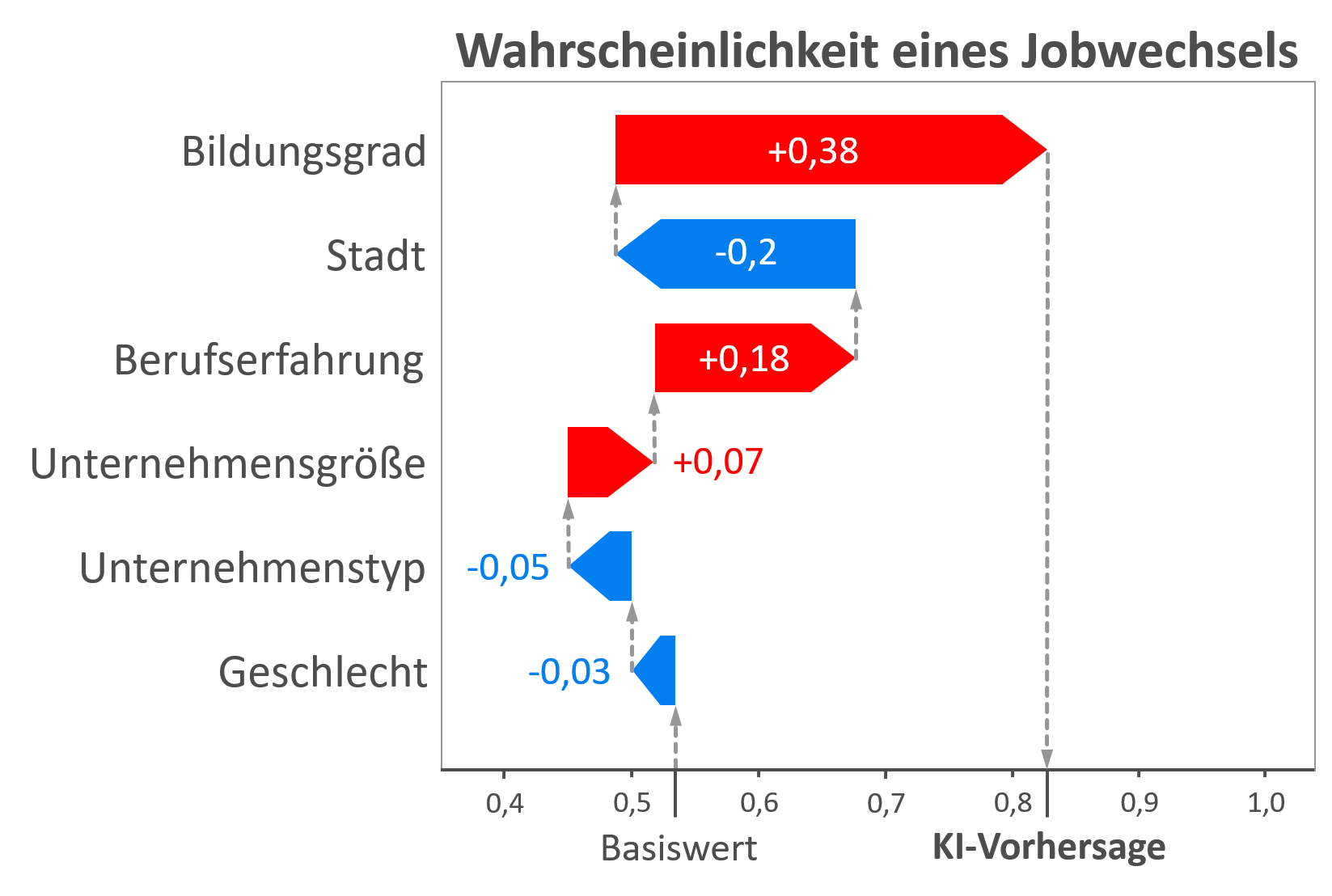

Die meisten Menschen nutzen oder interagieren täglich mit einer KI ohne dies aktiv zu bemerken. Sei es der Chatbot beim Kund:innenservice oder die automatische Gesichtserkennung auf dem Smartphone. Falsche oder fehlerhafte KI-Entscheidungen sind in diesen Fällen zwar ärgerlich, bleiben jedoch ohne gravierende Folgen für die Nutzenden. In vielen Einsatzgebieten wie der Produktion oder dem autonomen Fahren sind derartige Unsicherheiten jedoch nicht akzeptabel. Denn eine fehlerhafte Entscheidung des KI-Systems stellt in diesen Bereichen potenziell eine direkte Gefahr für den Menschen dar. Daher müssen hier höchste Anforderungen an die KI bezüglich ihrer Genauigkeit und Stabilität gestellt werden. Folglich gilt es, Methoden einer erklärbaren KI (explainable artificial intelligence; XAI) bereits während der Entwicklung solcher Systeme einzusetzen, damit eine KI nicht nur anhand von Metriken wie der Genauigkeit bewertet wird, sondern Entwickler:innen auch direkt das Zustandekommen der Entscheidungen nachvollziehen können. So kann beispielsweise identifiziert werden, ob die KI einen Fehler oder ungewollte Strukturen in den Trainingsdaten ausnutzt. Es ist jedoch nicht nur für Expert:innen interessant das Verhalten einer KI zu verstehen, sondern auch für Endnutzer:innen – in manchen Situationen sogar notwendig. Nach der Datenschutz-Grundverordnung (DSGVO) haben betroffene Personen bereits ein Recht auf Transparenz und Erklärung. Im Falle eines KI-Systems kann dies aufgrund der Black-Box-Problematik nur durch erklärbare und nachvollziehbare KI-Entscheidungen gewährleistet werden. Weitere Verordnungen, wie der Entwurf für eine KI-Verordnung (KI-VO-E), könnten künftig zusätzliche rechtliche Verpflichtungen bezüglich erklärbarer KI aufbringen.

Neben rechtlichen, sind ferner auch ethische Gründe für den Einsatz von XAI relevant. In diesem Kontext stellte die EU-Kommission „Ethik-Leitlinien für eine vertrauenswürdige KI“ vor, die Entwickler:innen sieben zu beachtende Schlüsselanforderungen für KI-Systeme an die Hand geben. Ganz allgemein soll eine KI die Nutzenden nach diesen Leitlinien bei der Entscheidungsfindung unterstützen, allerdings nie selbst eine Entscheidung über einen Menschen treffen. Dies soll gewährleisten, dass der Mensch stets die Entscheidungshoheit gegenüber der Technik besitzt. Am Beispiel des Finanzsektors soll so eine Diskriminierung einzelner Personengruppen bei der Kreditvergabe verhindert werden. XAI kann dabei helfen, Vertrauen in KI-Systeme zu schaffen und den Menschen zu befähigen, informierte Entscheidungen zu treffen.

Zielstellung

KARL möchte den aktuellen Stand der Technik zu XAI-Methoden zusammengetragen und die relevanten Informationen identifizieren, die dem Menschen eine KI-basierte Entscheidung nachvollziehbar machen. Dazu soll die Mensch-Maschine-Interaktion in erklärungswürdigen KI-Systemen anhand experimenteller Studien untersucht werden. In einer Reihe von Expert:inneninterviews sollen ferner Potenziale für den XAI-Einsatz im produzierenden Gewerbe identifiziert werden. Anhand verschiedener Anwendungsfälle soll dabei untersucht werden, wann XAI dazu beitragen kann, den Nutzen einer KI zu steigern und die mit ihrem Einsatz verbundenen Risiken zu minimieren.

Das Ergebnis der Recherche zu dem Stand der Technik wird in Form einer XAI-Schulung aufbereitet und um die Erkenntnisse aus den experimentellen Studien und der Potenzialanalyse ergänzt. Die Schulungsinhalte sollen nicht nur auf der KARL-Webseite zu finden sein, sondern werden Interessierten auch in Form eines interaktiven Workshops angeboten.

Konkret möchte KARL folgende Fragen beantworten:

• Welche Gründe gibt es für den Einsatz von XAI? Gibt es rechtliche und ethische Notwendigkeiten?

• Welche XAI-Methoden existieren und wann können sie eingesetzt werden?

• Was sind die Besonderheiten sowie Vor- und Nachteile einzelner XAI-Methoden?

• Wie lassen sich KI-Entscheidungen für den Menschen nachvollziehbar gestalten?

Der Fokus soll dabei auf der Anwendung von XAI für Endnutzer:innen liegen.

Handreichungen für Unternehmen

• XAI-Online-Kurs (Kurs zur Einführung in die Motivation hinter XAI, die Gründe für den XAI-Einsatz, die verschiedenen Zielgruppen einer Erklärung, wichtige Konzepte und konkrete XAI-Methoden)

• XAI-Workshop-Angebot (Präsenz-Veranstaltung zur Vermittlung von Grundlagenwissen zu erklärbarer KI anhand anschaulicher Anwendungsfälle, interaktiver Demonstratoren und Übungen)

• XAI-Auswahlsystematik (Tool zur Identifikation geeigneter XAI-Methoden für den eigenen KI-Anwendungsfall)

Nachvollziehbare KI-Entscheidungen

Relevanz

Die meisten Menschen nutzen oder interagieren täglich mit einer KI ohne dies aktiv zu bemerken. Sei es der Chatbot beim Kund:innenservice oder die automatische Gesichtserkennung auf dem Smartphone. Falsche oder fehlerhafte KI-Entscheidungen sind in diesen Fällen zwar ärgerlich, bleiben jedoch ohne gravierende Folgen für die Nutzenden. In vielen Einsatzgebieten wie der Produktion oder dem autonomen Fahren sind derartige Unsicherheiten jedoch nicht akzeptabel. Denn eine fehlerhafte Entscheidung des KI-Systems stellt in diesen Bereichen potenziell eine direkte Gefahr für den Menschen dar. Daher müssen hier höchste Anforderungen an die KI bezüglich ihrer Genauigkeit und Stabilität gestellt werden. Folglich gilt es, Methoden einer erklärbaren KI (explainable artificial intelligence; XAI) bereits während der Entwicklung solcher Systeme einzusetzen, damit eine KI nicht nur anhand von Metriken wie der Genauigkeit bewertet wird, sondern Entwickler:innen auch direkt das Zustandekommen der Entscheidungen nachvollziehen können. So kann beispielsweise identifiziert werden, ob die KI einen Fehler oder ungewollte Strukturen in den Trainingsdaten ausnutzt. Es ist jedoch nicht nur für Expert:innen interessant das Verhalten einer KI zu verstehen, sondern auch für Endnutzer:innen – in manchen Situationen sogar notwendig. Nach der Datenschutz-Grundverordnung (DSGVO) haben betroffene Personen bereits ein Recht auf Transparenz und Erklärung. Im Falle eines KI-Systems kann dies aufgrund der Black-Box-Problematik nur durch erklärbare und nachvollziehbare KI-Entscheidungen gewährleistet werden. Weitere Verordnungen, wie der Entwurf für eine KI-Verordnung (KI-VO-E), könnten künftig zusätzliche rechtliche Verpflichtungen bezüglich erklärbarer KI aufbringen.

Neben rechtlichen, sind ferner auch ethische Gründe für den Einsatz von XAI relevant. In diesem Kontext stellte die EU-Kommission „Ethik-Leitlinien für eine vertrauenswürdige KI“ vor, die Entwickler:innen sieben zu beachtende Schlüsselanforderungen für KI-Systeme an die Hand geben. Ganz allgemein soll eine KI die Nutzenden nach diesen Leitlinien bei der Entscheidungsfindung unterstützen, allerdings nie selbst eine Entscheidung über einen Menschen treffen. Dies soll gewährleisten, dass der Mensch stets die Entscheidungshoheit gegenüber der Technik besitzt. Am Beispiel des Finanzsektors soll so eine Diskriminierung einzelner Personengruppen bei der Kreditvergabe verhindert werden. XAI kann dabei helfen, Vertrauen in KI-Systeme zu schaffen und den Menschen zu befähigen, informierte Entscheidungen zu treffen.

Zielstellung

KARL möchte den aktuellen Stand der Technik zu XAI-Methoden zusammengetragen und die relevanten Informationen identifizieren, die dem Menschen eine KI-basierte Entscheidung nachvollziehbar machen. Dazu soll die Mensch-Maschine-Interaktion in erklärungswürdigen KI-Systemen anhand experimenteller Studien untersucht werden. In einer Reihe von Expert:inneninterviews sollen ferner Potenziale für den XAI-Einsatz im produzierenden Gewerbe identifiziert werden. Anhand verschiedener Anwendungsfälle soll dabei untersucht werden, wann XAI dazu beitragen kann, den Nutzen einer KI zu steigern und die mit ihrem Einsatz verbundenen Risiken zu minimieren.

Das Ergebnis der Recherche zu dem Stand der Technik wird in Form einer XAI-Schulung aufbereitet und um die Erkenntnisse aus den experimentellen Studien und der Potenzialanalyse ergänzt. Die Schulungsinhalte sollen nicht nur auf der KARL-Webseite zu finden sein, sondern werden Interessierten auch in Form eines interaktiven Workshops angeboten.

Konkret möchte KARL folgende Fragen beantworten:

• Welche Gründe gibt es für den Einsatz von XAI? Gibt es rechtliche und ethische Notwendigkeiten?

• Welche XAI-Methoden existieren und wann können sie eingesetzt werden?

• Was sind die Besonderheiten sowie Vor- und Nachteile einzelner XAI-Methoden?

• Wie lassen sich KI-Entscheidungen für den Menschen nachvollziehbar gestalten?

Der Fokus soll dabei auf der Anwendung von XAI für Endnutzer:innen liegen.

Handreichungen für Unternehmen

• XAI-Online-Kurs (Kurs zur Einführung in die Motivation hinter XAI, die Gründe für den XAI-Einsatz, die verschiedenen Zielgruppen einer Erklärung, wichtige Konzepte und konkrete XAI-Methoden)

• XAI-Workshop-Angebot (Präsenz-Veranstaltung zur Vermittlung von Grundlagenwissen zu erklärbarer KI anhand anschaulicher Anwendungsfälle, interaktiver Demonstratoren und Übungen)

• XAI-Auswahlsystematik (Tool zur Identifikation geeigneter XAI-Methoden für den eigenen KI-Anwendungsfall)

Robin Weitemeyer

Hochschule Karlsruhe

robin.weitemeyer@h-ka.de